Difference between revisions of "Test-rete-gdc"

(→Primi test) |

(→Primi test) |

||

| Line 30: | Line 30: | ||

== Primi test == | == Primi test == | ||

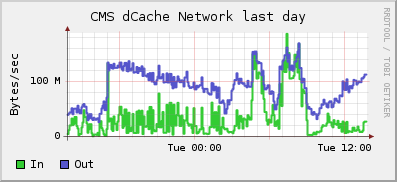

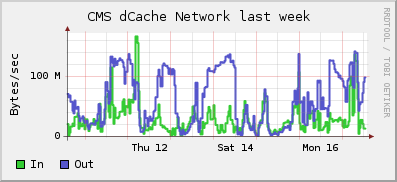

| − | Data l'attuale topologia di rete e configurazione dei server l'aggregato massimo che si si può aspettare fra WN e server di cache e' 2x1Gb/s ossia 250MB/s che si dimezzano nel caso di utilizzo "sbilanciato dei server". Previsione questa varificabile dalle statistiche di | + | Data l'attuale topologia di rete e configurazione dei server l'aggregato massimo che si si può aspettare fra WN e server di cache e' 2x1Gb/s ossia 250MB/s che si dimezzano nel caso di utilizzo "sbilanciato dei server". Previsione questa varificabile dalle statistiche di [http://farmsmon.pi.infn.it Ganglia] come si può anche vedere dai grafici di utilizzo della rete nell'ultimo giorno e settimana riportati di seguito: |

| − | [http://farmsmon.pi.infn.it | ||

| − | come si può anche vedere dai grafici di utilizzo della rete nell'ultimo giorno e settimana riportati di seguito: | ||

[[Image:net-dcache-day.png]] | [[Image:net-dcache-day.png]] | ||

[[Image:net-dache-week.png]] | [[Image:net-dache-week.png]] | ||

Revision as of 13:55, 17 February 2009

Scopo del lavoro

Scopo di questo lavoro è valutare le prestazioni dell'attuale configurazione di con particolare riguardo alle prestazioni dei sistemi storage. Nel fare questo si vuole quanto più possibile avere una valutazione slegata dall'applicativo che utilizza l'infrastruttura, per questo motivo si è deciso di "mimare" il comportamente tipico di un job in esecuzione sulla farm senza usare un vero job. Questo tipo di test sarà quindi ripertuto sulla nuova instrastruttura di rete per valutare i benefici ottenuti.

Installazione software

L'idea è di utilizzare il noto software "iperf" in due configurazioni distinte:

1- installato su alcuni server dcache e configurato come server per accettare le connessioni provenienti dalle macchine della farm;

2- installato su tutti i WN della farm grid ed utilizzato come client per collegarsi ai server di cui al punto 1, in questo modo simulando il comportamento del job che va ad accedere alle risorse di storage ma senza utilizzare l'infrastruttura di storage dell'esperimento.

Per quanto riguarda la farm il software è distribuito sia tramite AFS che GPFS quindi non è necessaria l'installazione su i singoli nodi, mentre per i server è stato installato su 5 macchine (cmsdcache7, 9, 10, 11, 12).

Topologia della rete attuale

Attualmente la rete del Grid Data Center è organizzate su due livelli in maniera stellare. I vari rack sono dotati di uno switch "top of the rack" che puo' essere interamente GE o FE ma comunque con un solo uplink di tipo GE verso un centro stella "di sala" costituito da una macchina Extreme Networks Summit 400-48.

I server dcache di CMS (15 in tutto) sono attestati su due switch di rack secondo la seguente disposizione:

- switch1: cmsdcache4, 5, 6

- switch2: cmsdcache2, 7, 9, 10, 11, 12, 13, 14, 15

- spenti: cmsdcache1, 3, 8

I sistemi operativi installati su questi server sono: Linux Ubuntu, Scientific Linux 5, Solaris, Open Solaris. Per fare il test sono stati presi i soli server con Scientific Linux 5.

Primi test

Data l'attuale topologia di rete e configurazione dei server l'aggregato massimo che si si può aspettare fra WN e server di cache e' 2x1Gb/s ossia 250MB/s che si dimezzano nel caso di utilizzo "sbilanciato dei server". Previsione questa varificabile dalle statistiche di Ganglia come si può anche vedere dai grafici di utilizzo della rete nell'ultimo giorno e settimana riportati di seguito: